Zastosowanie chłodzenia cieczą w centrach danych nabiera tempa ze względu na jego zdolność do bardziej wydajnego i skutecznego chłodzenia szaf IT o dużej gęstości. Dotychczas projektanci i operatorzy centrów danych nie dysponowali danymi, które można było wykorzystać do prognozowania wpływu chłodzenia cieczą na efektywność centrum danych i pomóc im optymalizować wdrażanie chłodzenia cieczą w celu zwiększenia efektywności energetycznej obiektów.

Aby wypełnić tę lukę, zespół specjalistów z NVIDIA i Vertiv przeprowadził pierwszą obszerną analizę wpływu chłodzenia cieczą na PUE i zużycie energii w centrach danych. Pełna treść analizy została opublikowana przez American Society of Mechanical Engineers (ASME) w artykule Analiza efektywności wykorzystania energii w hybrydowym centrum danych o wysokiej gęstości chłodzonym cieczą. W niniejszym wpisie przedstawiamy podsumowanie metodologii, wyników i najważniejsze wnioski płynące z tej analizy.

Metodologia analizy efektywności energetycznej chłodzenia cieczą w centrum danych

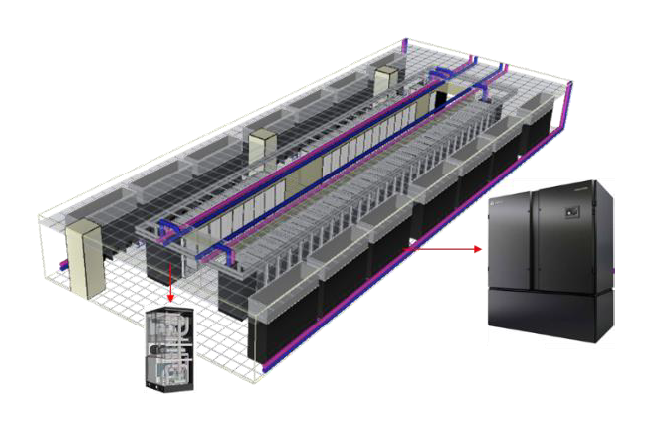

Do naszej analizy wybraliśmy centrum danych średniej wielkości (1–2 megawaty), Tier 2 w Baltimore w stanie Maryland. W obiekcie zainstalowano 50 szaf o wysokiej gęstości rozmieszczonych w dwóch rzędach. Punktem wyjściowym analizy było 100% chłodzenie powietrza przez dwa agregaty wody lodowej z obwodowymi centralami klimatyzacyjnymi do pomieszczeń komputerowych (CRAH) w konfiguracji gorących korytarzy. Jednostki chłodzące są obsługiwane przez agregat chłodniczy Vertiv™ Liebert® AFC z funkcjami freecoolingu, adiabatycznego freecoolingu, chłodzenia hybrydowego i adiabatycznego chłodzenia mechanicznego.

Chłodzenie cieczą jest możliwe dzięki bezpośredniemu chłodzeniu układu scalonego (direct-to-chip) przez mikrokanałowe płyty chłodnicze zamontowane na głównych elementach IT generujących ciepło i obsługiwanemu przez dwie jednostki dystrybucji chłodziwa (CDU) Vertiv™ Liebert® XDU z wymiennikami ciepła typu ciecz-ciecz.

Schemat centrum danych wykorzystany do analizy energetycznej z wykorzystaniem Vertiv™ Liebert® XDU i Vertiv™ Liebert® PCW.

W analizie zastosowano podejście „oddolne” poprzez rozdzielenie obciążenia IT na podsystemy, które umożliwiło dokładne obliczenie wpływu stopniowego wzrostu procentu obciążenia chłodzonego cieczą dla każdego podsystemu. Następnie przeprowadziliśmy cztery badania, zwiększając procent chłodzenia cieczą w każdym badaniu, jednocześnie wdrażając optymalizację temperatury wody lodowej, temperatury powietrza zasilającego i wtórnej temperatury wlotowej możliwe dzięki zastosowaniu chłodzenia cieczą.

- Badanie 1: 100% chłodzenie powietrzem przy temperaturze wody lodowej 7,2 stopni Celsjusza (45 stopni Fahrenheita), temperaturze powietrza nawiewanego 25°C (77°F) i wtórnej temperaturze wlotowej 32°C (89,6°F).

- Badanie 2: 61,4% obciążenia jest chłodzone cieczą, a 38,6% chłodzone powietrzem. Temperatura wody lodowej wzrasta do 18°C (64,4°F), temperatura powietrza zasilającego jest utrzymywana na poziomie 25°C (77°F), a wtórna temperatura wlotowa jest utrzymywana na poziomie 32°C (89,6°F).

- Badanie 3: 68,6% obciążenia jest chłodzone cieczą, a 31,4% chłodzone powietrzem. Temperatura wody lodowej wzrasta do 25°C (77°F), temperatura powietrza zasilającego jest podnoszona do 35°C (95°F), a wtórna temperatura wlotowa jest utrzymywana na poziomie 32°C (89,6°F).

- Badanie 4: 74,9% obciążenia jest chłodzone cieczą, a 25,1% chłodzone powietrzem. Temperatura wody lodowej jest utrzymywana na poziomie 25°C (77°F), temperatura powietrza nawiewanego jest utrzymywana na poziomie 35°C (95°F), a wtórna temperatura wlotowa jest podnoszona do 45°C (113°F).

Wpływ wdrożenia chłodzenia cieczą na zużycie energii w centrum danych i PUE

Pełne wdrożenie chłodzenia cieczą w Badaniu 4 (74,9%) przyniosło zmniejszenie zużycia energii w obiekcie o 18,1% i zmniejszenie całkowitego zużycia energii w centrum danych o 10,2% w porównaniu do 100% chłodzeniem powietrzem. Efektem tego jest nie tylko obniżenie kosztów energii centrum danych o 10% rocznie, ale także zmniejszenie o tę samą wartość emisji Zakresu 2 w centrach danych wykorzystujących źródła energii oparte na węglu.

Całkowite zużycie energii w centrum danych zmniejszało się wraz z każdym wzrostem procentowym obciążeń chłodzonych metodą direct-to-chip. W okresie od Badania 1 do Badania 2 pobór mocy został zmniejszony o 6,4%; między Badaniem 2 i 3 uzyskano dodatkowe 1,8% ograniczenie; a między Badaniem 3 i 4 zaobserwowano kolejną poprawę o 2,5%.

Na podstawie tych wyników wartość PUE dla centrum danych obliczona dla każdego badania może okazać się zaskakująca. Wartość wskaźnika PUE spadła tylko o 3,3% z poziomu 1,38 w Badaniu 1 do 1,34 w Badaniu 4 i w rzeczywistości pozostała bez zmian na poziomie 1,35 dla Badań 2 i 3.

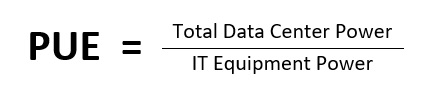

Jeśli znasz sposób obliczania PUE, być może już domyśliłeś się powodu tej rozbieżności. PUE jest zasadniczo miarą wydajności infrastruktury, która jest obliczana poprzez podzielenie całkowitej mocy zasilania centrum danych przez moc IT. Jednak chłodzenie cieczą nie tylko ograniczyło zużycie energii po stronie obiektu, ale także zmniejszyło pobór mocy przez IT (zgodnie z definicją PUE), zmniejszając zapotrzebowanie na pracę wentylatorów serwerów.

Pobór mocy przez wentylator serwera zmniejszył się o 41% pomiędzy Badaniem 1 a Badaniem 2 oraz o 80% pomiędzy Badaniem 1 a Badaniem 4. Spowodowało to zmniejszenie poboru energii przez IT o 7% pomiędzy Badaniem 1 a 4.

Chłodzenie cieczą, w przeciwieństwie do chłodzenia powietrzem, wpływa zarówno na licznik (całkowite zasilanie centrum danych), jak i na mianownik (zasilanie sprzętu IT) w obliczeniach PUE, co czyni go nieskuteczną miarą porównywania wydajności systemów chłodzenia cieczą i powietrzem.

W naszym opracowaniu proponujemy stosowanie wskaźnika Całkowitej efektywności wykorzystania (TUE) jako lepszą miarę dla tego celu, a w kolejnym poście wyjaśnimy, dlaczego podjęto taką decyzję. Wskaźnik TUE dla centrum danych, które było przedmiotem naszej analizy, poprawił się o 15,5% pomiędzy Badaniem 1 a 4, co naszym zdaniem odpowiada dokładnej wartości wzrostu wydajności centrum danych osiągniętego dzięki wdrażaniu zoptymalizowanego chłodzenia cieczą.

Najważniejsze wnioski płynące z analizy efektywności energetycznej chłodzenia cieczą w centrum danych

Analiza dostarczyła wielu spostrzeżeń dotyczących efektywności chłodzenia cieczą w centrum danych i sposobów jego optymalizacji. Zachęcam w szczególności projektantów centrów danych do przeczytania całego artykułu, który obejmuje dane uzupełniające wykorzystane do uzyskania wyników określonych w poprzednich paragrafach. Poniżej przedstawiam kilka kluczowych wniosków, które mogą zainteresować szerszą publiczność.

- W centrach danych o dużej gęstości chłodzenie cieczą zapewnia poprawę efektywności energetycznej systemów IT i obiektu w porównaniu z chłodzeniem powietrzem. W naszym w pełni zoptymalizowanym badaniu wdrożenie chłodzenia cieczą spowodowało zmniejszenie całkowitego zasilania centrum danych o 10,2% i ponad 15% poprawę TUE.

- Maksymalizacja wdrożenia chłodzenia cieczą w centrum danych — pod względem procentowego udziału obciążenia IT chłodzonego cieczą — zapewnia największą efektywność. W przypadku chłodzenia direct-to-chip nie jest możliwe schłodzenie całego za pomocą cieczy, ale około 75% obciążenia może być skutecznie chłodzone tą metodą.

- Chłodzenie cieczą umożliwia stosowanie wyższych temperatur wody lodowej, powietrza zasilającego i wtórnego temperatury wlotowej, które przyczyniają się do maksymalizacji efektywności infrastruktury obiektu. Należałoby rozważyć w szczególności chłodzenie gorącą wodą. Wtórne temperatury wlotowe w naszym ostatnim badaniu zostały podniesione do 45°C (113°F), co przyczyniło się do uzyskania osiągniętych wyników, jednocześnie zwiększając możliwości ponownego wykorzystania odpadowego ciepła.

- PUE nie jest dobrym miernikiem efektywności chłodzenia cieczą w centrum danych, a inne metryki, takie jak TUE, okażą się bardziej pomocne w podejmowaniu decyzji projektowych związanych z wprowadzeniem chłodzenia cieczą w centrum danych chłodzonym powietrzem.

Na koniec chciałbym podziękować moim współpracownikom z Vertiv i NVIDIA za ich pracę nad tą przełomową analizą. Jej wyniki nie tylko pozwalają zmierzyć ilościowo oszczędności energii, które można osiągnąć dzięki chłodzeniu cieczą, ale dostarczają projektantom cennych danych, które można wykorzystać do optymalizacji instalacji chłodzenia cieczą w centrach danych.

Więcej informacji na temat trendów wpływających na stosowanie chłodzenia cieczą można znaleźć w wpisie na blogu Chłodzenie cieczą: Rozwiązania dla centrów danych do przetwarzania danych o wysokiej gęstości, który podsumowuje wnioski z panelu ekspertów w dziedzinie chłodzenia cieczą, który odbył się podczas szczytu OCP Global Summit 2022.